2.561 fehlende Alt-Attribute, 978 doppelte Title Tags, auf 722 Seiten fehlt die H2, 11.243 Seiten haben keine Meta Description.

Ist das das Ende der Sichtbarkeit meiner Website in den Suchergebnissen?

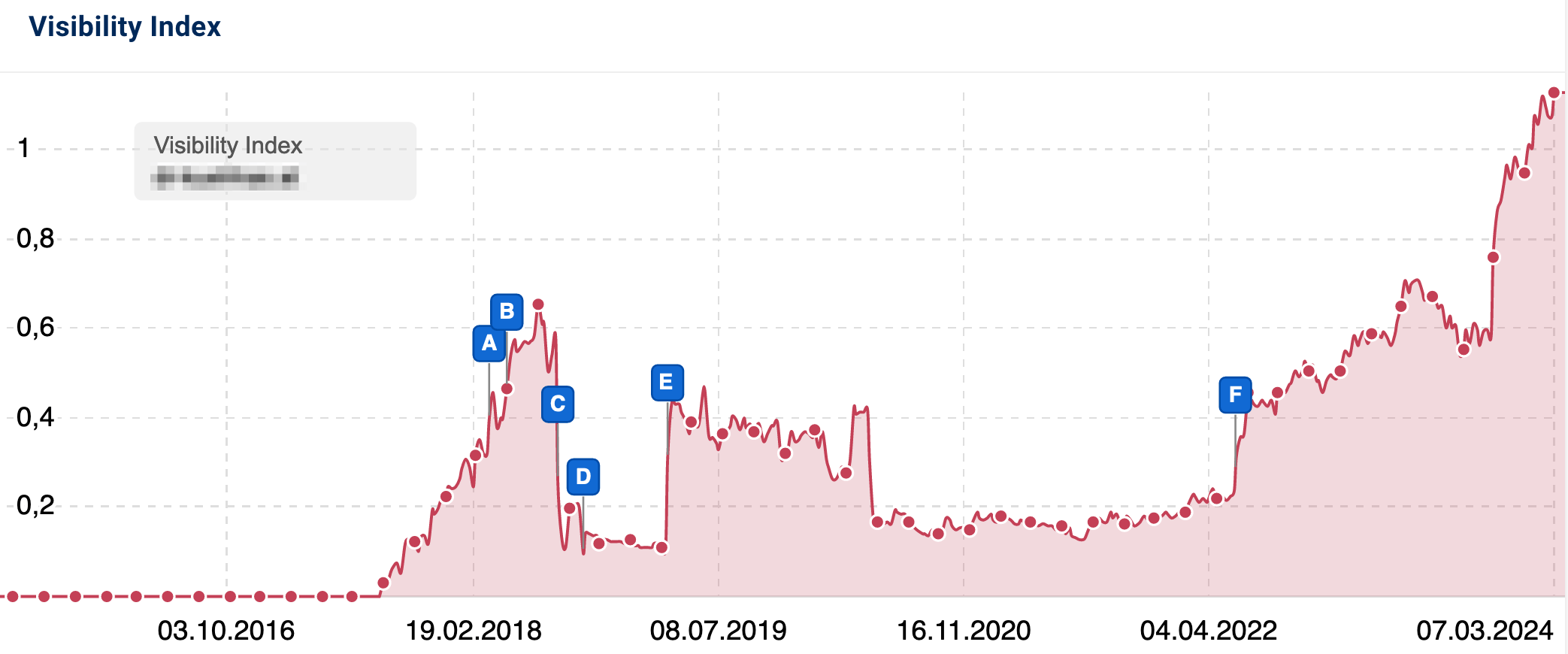

Nein, keineswegs. Nicht jedes “Problem” in Online-Marketing-Tools ist ein echtes Problem und nicht alle Daten sind relevante Daten. Wenn man versteht, wie SEO-Tools funktionieren und wie ihre Daten zu deuten sind, sind sie mächtige Begleiter und helfen uns enorm bei der Arbeit. Werden die Metriken und Zahlen allerdings missverstanden oder aus dem Zusammenhang gerissen, können sie zu falschen Schlussfolgerungen führen und Zeit und Geld verbrennen.

In diesem Artikel sehen wir uns einige der häufigsten Missverständnisse rund um SEO-Tools an und wie sie gezielt eingesetzt sowie die ausgespielten Daten sinnvoll interpretiert werden können.

SEO-Tools und ihre Daten

Mithilfe von SEO-Tools können verschiedene Faktoren einer Website analysiert und in Form von Zahlen Ergebnisse ausgespielt werden. Darin sind die Programme unschlagbar, sowohl was die Präzision als auch die Effizienz betrifft. Was sie allerdings nicht können, ist die richtige Interpretation dieser Ergebnisse. Es liegt an uns, zu entscheiden, wie aussagekräftig die Zahlen sind, und davon die richtigen Schlussfolgerungen abzuleiten.

Es ist die Aufgabe der Tools, Daten auszuspielen. Es ist unsere Aufgabe, diese Daten zu interpretieren.

Denn ohne eine kontextabhängige Interpretation haben die Zahlen keine Bedeutung und somit auch keinen Bezug zur Realität. Nur wer die Zahlen versteht und ihre Relevanz beurteilen kann, kann auch die richtigen Entscheidungen zu notwendigen Optimierungsmaßnahmen treffen. Genau darum soll es im Folgenden gehen: die richtigen Aktionen aus den Zahlen abzuleiten.

Don’t panic: Nicht jedes Problem ist ein Problem

Die zentrale Aufgabe von SEO-Tools ist es, Fehler zu finden. Also finden sie auch Fehler – auf so gut wie jeder Website. Vor allem Einsteiger oder Website-Betreiber ohne fundierte SEO-Kenntnisse können die zahlreichen „Warnungen“ und „Fehler“ diverser SEO-Tools schnell verunsichern. Nur wie aussagekräftig sind solche Fehlermeldungen wirklich? Bevor man also in Panik verfällt, sollte man erstmal tief durchatmen und sich fragen:

- Welche Fehler sind relevant und welche irrelevant?

- Welche Probleme müssen unbedingt gelöst werden, welche sind nur Schönheitsfehler und welche Probleme sind gar keine Probleme?

- Was hat tatsächlich Auswirkungen auf die Rankings und die User Experience?

- Und nicht zuletzt: Wie groß ist der Aufwand, um den Fehler zu beheben? Lohnt es sich oder steht der Aufwand in keiner Relation zur Wirkung?

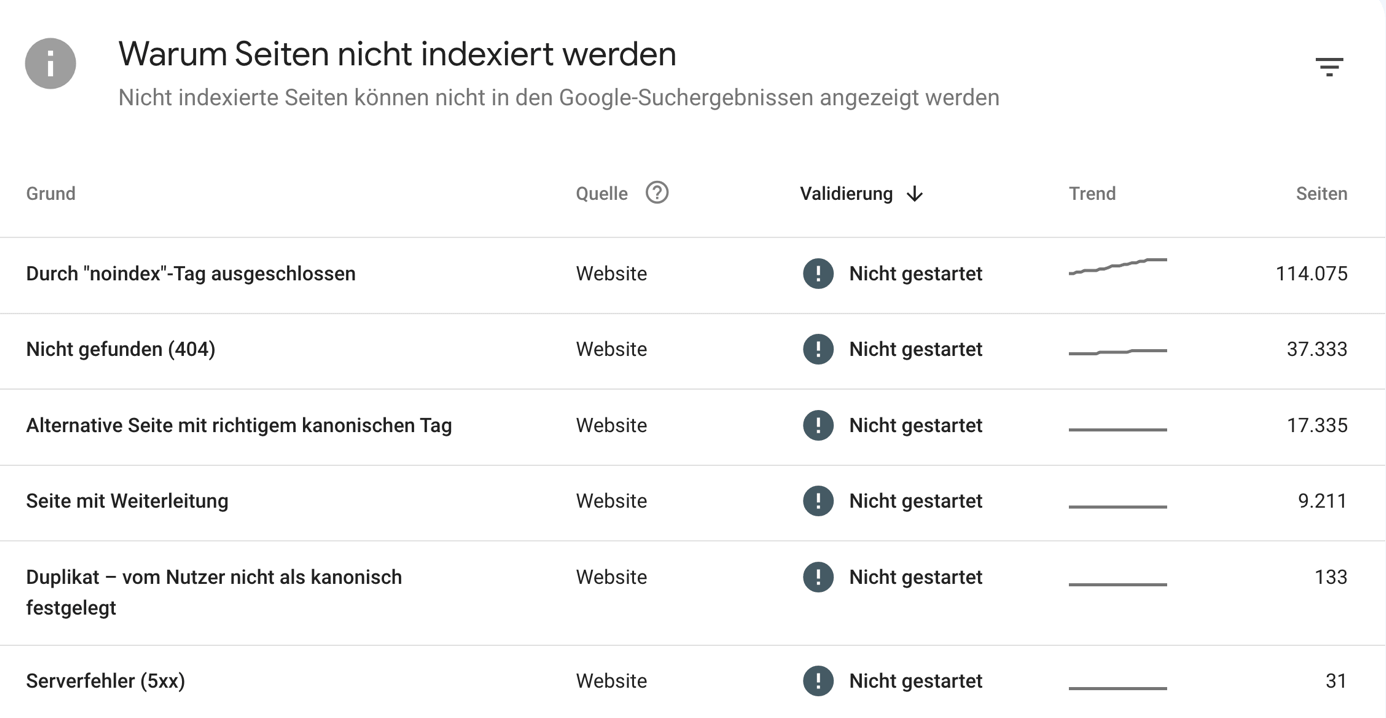

Warnungen in der Google Search Console

Schauen wir uns zuerst das wohl wichtigste Tool an, das Webmastern und SEOs zur Verfügung steht: die Google Search Console. Es handelt sich um das einzige Tool, das Daten direkt von Google bereitstellt. Wir empfehlen jedem, der eine Website betreibt oder Websites baut, diese in der Google Search Console zu verifizieren, um Zugang zu diesen Daten zu erhalten.